escrito por Antonny Santos (Solutions Architect Lead)

escrito por Antonny Santos (Solutions Architect Lead)

Atribuição não é um modelo. É um sistema.

Grande parte das discussões sobre atribuição começa com perguntas como: “Deveríamos usar last-click, first-touch ou multi-touch?”

Essa já é uma pergunta equivocada.

Atribuição não se resume à escolha de um modelo. É um problema de design de sistema, operando sob uma restrição causal que raramente é explicitada. E não pertence a uma única disciplina. A atribuição vive no meio do caos—no ponto de encontro entre análise de produto, execução de marketing, resolução de identidade e governança de dados.

Quando a atribuição falha, geralmente não é por conta do modelo escolhido. Ela falha porque o sistema não foi projetado para lidar com a complexidade que deveria explicar.

Um olhar para trás: como chegamos aqui?

Vale lembrar que a maioria das ferramentas de atribuição evoluiu a partir de modelos mais simples. Modelos como first-click, last-click e lineares foram criados em uma época de jornadas mais curtas, dados mais ruidosos e menos pontos de contato.

Com a complexificação das jornadas de usuário e a multiplicidade de canais, as equipes passaram a incorporar mais dados e modelos mais sofisticados—como a atribuição algorítmica ou baseada em dados.

Mas mesmo os modelos mais avançados ainda se baseiam em uma suposição problemática: que o que se observa pode explicar com clareza o que causou um comportamento. Os modelos se tornaram mais complexos, mas as questões fundamentais permaneceram.

E assim, a atribuição continuou falhando—de formas mais sutis e caras.

A restrição central: observação vs. intervenção

Sistemas de atribuição são construídos quase inteiramente com dados observacionais. Observa-se que uma pessoa foi exposta a uma campanha, e mais tarde ocorreu uma conversão. Com base em uma sequência de eventos, tenta-se atribuir significado.

Mas a pergunta que a atribuição deveria responder—“Vale a pena investir mais aqui?”—não é observacional. É contrafactual. O que realmente se deseja saber é:

O que teria acontecido se essa exposição não tivesse ocorrido?

Essa é uma pergunta de intervenção. E essa distinção é essencial.

Em termos formais, a maioria dos sistemas de atribuição usa fórmulas como:

P(Y∣X)

Onde X é a exposição e Y é o evento de conversão. Mas o que se busca responder está mais próximo de:

P(Y∣do(X))

O operador do(·) indica uma intervenção—algo que altera deliberadamente o sistema, independentemente do comportamento, intenção ou contexto do usuário.

Essa lacuna entre P(Y∣X) e P(Y∣do(X)) não é uma falha de ferramenta. É uma propriedade fundamental de sistemas causais. Todo modelo de atribuição—do last-click ao multi-touch ou baseado em dados—é apenas uma aproximação, muitas vezes imprecisa, dessa ponte.

A maioria dos stacks ignora essa diferença. Apenas a esconde com ponderações.

De onde vem o conceito de “do(X)”?

Ele vem do campo da inferência causal, especialmente do trabalho de Judea Pearl. Em termos simples, dados observacionais mostram o que aconteceu. Já as perguntas causais pedem que se imagine o que teria acontecido se apenas uma variável fosse alterada.

Ferramentas de atribuição tentam responder a perguntas causais usando dados observacionais. Mas sem experimentos randomizados (em que a exposição é controlada), não há como isolar causa e efeito com precisão. Esse é o verdadeiro desafio. Não é uma falha da ferramenta—é uma limitação dos dados e do sistema que os sustenta.

Por que a atribuição falha na prática

Essa limitação causal se soma a três problemas estruturais presentes na maioria das organizações:

1. A resolução de identidade é incompleta ou implícita.

A atribuição assume uma noção estável e unificada de “usuário”. Na prática, essa identidade é fragmentada.

O marketing enxerga cookies e IDs de dispositivos. Já o time de produto trabalha com contas e sessões logadas. No CRM, o foco está em e-mails e registros de clientes. Na mídia paga, entra em cena mais uma camada de identificadores, às vezes probabilísticos.

Quando a pergunta é: “Essas interações vêm da mesma pessoa?”, muitas vezes não há uma resposta segura.

Com identidade fraca, as jornadas se fragmentam, as janelas de atribuição colapsam e a análise entre canais se torna fictícia. Esse não é um cenário raro—é o padrão.

2. Os eventos não são governados.

A atribuição pressupõe que os eventos são bem definidos e rastreados com consistência. Na prática, eventos são renomeados, reutilizados ou reinstrumentados. Propriedades mudam. Marketing e produto frequentemente emitem versões diferentes da mesma ação.

Sem governança, a atribuição se torna irreproduzível. Comparações históricas perdem validade. E os modelos acabam otimizando ruído. Nenhum modelo compensa dados indefinidos ou instáveis.

3. Marketing e produto otimizam métricas diferentes.

Marketing olha para alcance, cliques, CPA, desempenho de canais. Produto analisa ativação, retenção, LTV, uso de funcionalidades. A atribuição está entre essas áreas—mas geralmente não é liderada por nenhuma delas.

O resultado é que marketing relata sucessos que produto não vê. Produto detecta quedas que marketing não consegue explicar. A atribuição deixa de ser uma ferramenta de aprendizado e passa a ser um artefato político.

Esse desalinhamento organizacional é tão prejudicial quanto qualquer falha técnica.

O verdadeiro modo de falha

No fim das contas, a atribuição não falha por escolher o modelo errado. Ela falha porque não consegue responder com confiança a quatro perguntas essenciais:

Quem é essa pessoa, de fato?

(resolução de identidade)

O que aconteceu exatamente, e em que ordem?

(qualidade e sequência dos eventos)

Quais ações foram apenas correlacionadas, e quais causaram mudanças reais?

(diferença entre observação e intervenção)

Qual é o resultado que realmente importa para o negócio?

(métrica de produto vs. métrica de canal)

Se qualquer um desses elementos falhar, a atribuição vira apenas uma encenação na distribuição de créditos.

O que vem a seguir

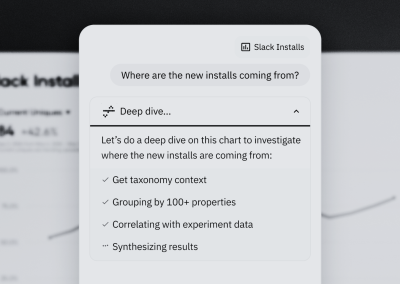

Este texto foca intencionalmente no problema. A atribuição costuma ser tratada como uma decisão de modelagem, mas os verdadeiros pontos de falha estão antes disso—na forma como se trata a identidade, os dados, os limites organizacionais e os dados observacionais.

Nos próximos artigos, será abordado como operar dentro dessas restrições: reduzir viés na prática, entender a diferença entre comportamento próprio e pago, e usar ferramentas de analytics de produto não para “resolver” a atribuição, mas para refletir sobre ela com mais clareza e honestidade.

Sua atribuição já quebrou assim?

Identidades fragmentadas. Eventos fora de controle. Métricas celebradas que não refletem o impacto real. Quando essas situações ocorrem, não são casos isolados.

Na Minders, ajudamos equipes a construir sistemas de atribuição que refletem como o crescimento realmente funciona. Seja para repensar a estratégia ou validar hipóteses, é sempre valioso trocar experiências. Vamos falar!